Sind kostenlose Digitale Bibliotheken ein Ausweg aus der Zeitschriftenkrise?

Institut für Soziologie

TU Darmstadt

Abstract

Die Self-Archiving und Open-Access Community hat den grossen Wissenschaftsverlagen (Elsevier, Springer, Kluwer, etc.) den Kampf erklärt: Nach jahrelangen enormen Preissteigerungen bei wissenschaftlichen Zeitschriften - teilweise im zweistelligen Bereich jährlich, stagnierenden Bibliotheksetats und zunehmender Aufgabenfülle der Bibliotheken kam es zu schweren Einschnitten bei der Beschaffung von Monografien sowie massiven Abbestellungen von Zeitschriftenabos. Wissenschaftliche Bibliotheken und Fachgesellschaften wehren sich nun und

bilden Bibliothekskonsortien, die den Verlagen mit größerer Verhandlungsmacht gegenübertreten und so deutlich bessere Preise und Abnahmekonditionen aushandeln

organisieren Self-Archiving Projekte (Preprint Server, Open Archives Initiative, Budapest Open Access Initiative)

finden Neugründungen von qualitativ hochstehenden Open-Access Zeitschriftentiteln statt, die den hochpreisigen etablierten Titeln Konkurrenz machen (Scholarly Publishing and Academic Ressources Coalition)

ganze editorial boards werden dazu animiert, mit den Verlagen von überteuerten Zeitschriften in Verhandlungen zu treten, mit dem Ziel, die Abo-Preise zu senken.

drohen wissenschaftliche Fachgesellschaften mit dem Boykott von Verlagen

In dem Beitrag werden aktuelle technisch-ökonomisch-soziale Hintergründe der sogenannten Zeitschriftenkrise beschrieben, der Markt für wissenschaftliche Publikationen (Verlage, Bibliotheken, Zeitschriftenagenturen, Fachinformationseinrichtungen, etc.) analysiert sowie die wichtigsten Initiativen der Self-Archiving oder Open-Access Community vorgestellt. Letztere werden aus marxistischer Sicht kritisch unter die Lupe genommen und in Bezug zu Ansätzen der Freien Software Bewegung, Open Source und Open Content Lizenzmodellen gesetzt.

Links

- http://www.openarchives.org/

Open Archives Initiative (OAI)

Open Archives Initiative (OAI)

- http://www.arl.org/sparc/home/index.asp?page=0

Scholarly Publishing and Academic Ressources Coalition (SPARC)

Scholarly Publishing and Academic Ressources Coalition (SPARC)

- http://www.soros.org/openaccess/

Budapest Open Access Initiative (BOAI)

Budapest Open Access Initiative (BOAI)

Einleitung: Der Markt für elektronische Fachinformation

Laut einer Studie von Outsell Inc. hat der Markt für Scientific Technical Medical (STM) Fachinformationen im Jahr 2000 einen Umfang von 9,5 Mrd US$. (Outsell 2000) Die laut eigenen Angaben weltweit größte Zeitschriftenagentur SwetsBlackwell rühmt sich ihren Kunden etwa 250.000 Zeitschriftentitel von 65.000 Verlagen zugänglich machen zu können (allerdings nur 7.156 als elektronische Volltexte). Die Elektronische Zeitschriftenbibliothek in Regensburg vermittelt 12.247 Titel von denen 3037 im Volltext frei zugänglich sind, der Rest wird von den Bibliotheken teuer bezahlt. Ein Abo einer physikalischen Zeitschrift kostet im Schnitt 1879$, das einer biologischen 996$, das einer geographischen 655$. Eine durchschnittliche wissenschaftliche Bibliothek bezieht ständig mehrere tausend Zeitschriften.

Etwa 35% (6,4 Mrd DM) des Umsatzes des deutschen Buchmarkts von 18 Mrd DM wurden im Jahr 2000 mit Fachbüchern, Wissenschaft und Schulbüchern gemacht und 9,9% (1,8 Mrd DM) mit Fach- und wissenschaftlichen Zeitschriften. 1 (Tab. 1)

(Tab. 1)

| Jahr | 1996 | 1997 | 1998 | 1999 | 2000 | ||||||

| Mio. DM | Anteil in % | Mio. DM | Anteil in % | Mio. DM | Anteil in % | Mio. DM | Anteil in % | Mio. DM | Anteil in % | Veränd in % | |

| Fachbuch/Wissenschaft/Schulbuch | 6.032 | 35,0 | 6.080 | 34,7 | 6.232 | 35,1 | 6.295 | 34,9 | 6.402 | 34,7 | + 1,7 |

| Fach- und wissenschaftliche Zeitschriften | 1.648 | 9,6 | 1.738 | 9,9 | 1.830 | 10,3 | 1.849 | 10,2 | 1.816 | 9,9 | - 1,8 |

Der Anteil der elektronischen Fachinformation am gesamten deutschen Online Markt (2,6 Mrd DM) betrug 1998 lediglich 2,9% (62 Mio DM), zusammen mit den allgemeinen Hosts (399 Mio DM) 22%. (Bredemeier 1998)

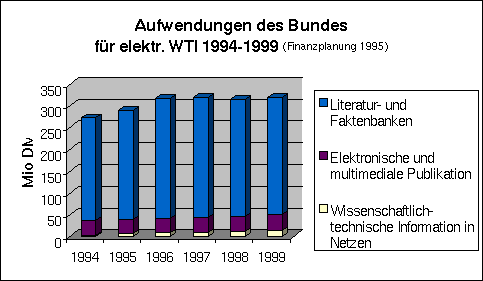

Die öffentliche Förderung elektronischer Fachinformation verteilt sich auf die Hochschulen und deren wissenschaftlichen Bibliotheken sowie auf die Einrichtungen der außeruniversitären Forschung und Informationsinfrastruktur (Grossforschungseinrichtungen, Fraunhofergesellschaft, Fachinformationszentren, etc.) In den Jahren 1996 bis 1999 wurde dafür über 1.9 Mrd DM ausgegeben, allein im Jahr 1999 über 480 Mio DM. (Tab. 2)

| Ausgaben in Mio DM | |||||||

| Schwerpunkte | 1994 | 1995 | 1996 | 1997 | 1998 | 1999 | 1996-1999 |

| 1. Wiss.-techn. Information in Netzen | 3,4 | 6,6 | 8,7 | 10,2 | 11,3 | 13,8 | 44,0 |

| 2. Elektronische und multimediale Publikation | 32,9 | 32,5 | 33,5 | 34,9 | 35,6 | 37,1 | 141,1 |

| 3. Literatur- und Faktenbanken | 236,3 | 249,8 | 274,9 | 274,9 | 268,2 | 269,1 | 1.087,1 |

| 4. Wissenschaftliche Bibliotheken | 143,9 | 141,4 | 150,9 | 151,3 | 153,1 | 152,3 | 607,6 |

| 5. Nutzung der wiss.-techn. Information | |||||||

| - Hochschulen und F+E-Einrichtungen | 7,0 | 5,9 | 3,7 | 4,5 | 5,3 | 6,3 | 19,8 |

| - Wirtschaft | 7,3 | 7,2 | 7,3 | 7,1 | 7,1 | 2,1 | 23,6 |

| Summe: | 430,8 | 443,4 | 479,0 | 482,9 | 480,6 | 480,7 | 1.923,2 |

Werden nur die klar als elektronische Fachinformation identifizierbaren Posten (Ziffer 1-3) dieser Tabelle aufsummiert, so zeigt sich, dass diese Ausgaben seit 1996 nicht mehr weiter angestiegen sind und seitdem bei etwa 315 Mio DM pro Jahr stagnierten. Der grösste Teil dieser Ausgaben (1999 über 84% bzw. 269 Mio DM) wird für Literatur- und Faktenbanken verwendet. (Abb. 1)

Abbildung 1: Aufwendungen des Bundes für elektronische WTI 1994-1999

Quelle: BMBF 1996

Hauptabnehmer von Fachzeitschriften - egal ob elektronisch oder nicht - sind wissenschaftliche Bibliotheken. Nur zwischen 3 und 4 Prozent der gesamten Hochschulausgaben (1999: 35,7 Mrd DM) werden für die Hochschulbibliotheken verwendet. Laut Deutscher Bibliotheksstatistik gab es 1998 in Deutschland 1.211 wissenschaftliche Bibliotheken 2 mit einem Gesamtbestand von 273 Mio Einheiten. Für sie wurden im Jahr 1998 1.3 Mrd DM ausgegeben. 3

mit einem Gesamtbestand von 273 Mio Einheiten. Für sie wurden im Jahr 1998 1.3 Mrd DM ausgegeben. 3 Die Erwerbungskosten von Büchern und Zeitschriften schlugen 1998 an wissenschaftlichen Bibliotheken mit 666 Mio DM zu Buche. (DBS 1998)

Die Erwerbungskosten von Büchern und Zeitschriften schlugen 1998 an wissenschaftlichen Bibliotheken mit 666 Mio DM zu Buche. (DBS 1998)

Zeitschriftenkrise und Self-Archiving

Seit etwa 200 Jahren ist eine rasante Zunahme der Produktion wissenschaftlicher Texte und eine zunehmende Ausdifferenzierung der Wissenschaft in einzelne Spezialgebiete zu beobachten. Die Zahl der jährlich publizierten wissenschaftlichen Artikel verdoppelte sich in den letzten 200 Jahren alle 10-15 Jahre. (Price 1956) Das Wachstum über die Jahrhunderte war jedoch nicht gleichmässig sondern hat mit der Zeit zugenommen. In der Zeit nach dem 2. Weltkrieg verdoppelte sich die Anzahl der publizierten Artikel in der Mathematik alle 10 Jahre. (Odlyzko 1995, 5 ff)

Die Anzahl der wissenschaftlichen Journale ist von unter 10 (zu Beginn des 18 Jahrhunderts) bzw. etwa 100 (zu Beginn des 19. Jahrhunderts) auf über 10.000 (zu Beginn des 20. Jahrhunderts) gestiegen. Derzeit wird die Anzahl der wissenschaftlichen Journale (je nachdem, wie weit man den Rahmen von 'wissenschaftlich' bzw. 'wissenschaftlich relevant' faßt) mit 150.000 bis 400.000 veranschlagt.

(Grötschel and Luegger 1995)

Wegen jährlicher Preissteigerungen im - je nach Fach und Zeitschrift - bis zu zweistelligen Bereich 7-15% (wg. Monopolstrukturen 4 im wissenschaftlichen Zeitschriftenmarkt, Kursverlusten des Euros, Zunahme von Zahl und Umfang der Zeitschriften bei immer kleiner werdendem Abonnentenkreis) und stagnierenden Bibliotheksetats kam es in den letzten Jahren zu Abbestellungen von Abos und einem reduzierten Zukauf von Monografien. Die Verlage berechnen die Abogebühren aufgrund der gesunkenen Abonnentenzahlen neu und erhöhen die Preise, was wiederum zu weiteren Abbestellungen führt. Dieser ganze Vorgang wird als eine Preisspirale gesehen, die dem gesamten Publikationswesen für wissenschaftliche Literatur schadet. Die Zuspitzung dieser Entwicklung wird mit dem Begriff Zeitschriftenkrise gekennzeichnet.

im wissenschaftlichen Zeitschriftenmarkt, Kursverlusten des Euros, Zunahme von Zahl und Umfang der Zeitschriften bei immer kleiner werdendem Abonnentenkreis) und stagnierenden Bibliotheksetats kam es in den letzten Jahren zu Abbestellungen von Abos und einem reduzierten Zukauf von Monografien. Die Verlage berechnen die Abogebühren aufgrund der gesunkenen Abonnentenzahlen neu und erhöhen die Preise, was wiederum zu weiteren Abbestellungen führt. Dieser ganze Vorgang wird als eine Preisspirale gesehen, die dem gesamten Publikationswesen für wissenschaftliche Literatur schadet. Die Zuspitzung dieser Entwicklung wird mit dem Begriff Zeitschriftenkrise gekennzeichnet.

Seit etwa den 80er Jahren tobt im Wissenschaftsbetrieb eine hochemotional geführte Debatte zu den Veränderungen in der Publikationskette, den enormen Preissteigerungen für sowohl gedruckte als auch elektronische Zeitschriften sowie den vielfältigen Vorschlägen, wie dem Dilemma der Preisspirale zu entkommen sei. Dabei wird immer wieder die scheinbar absurde Situation thematisiert, dass die staatlich finanzierte Wissenschaft ihre Verbreitungs- und Verwertungsrechte an (nicht nur) kommerzielle Verlage 5 abtritt und nach dem Peer-Review-Verfahren (bei dem wiederum Reviewer aus dem Wissenschaftsbetrieb die Hauptarbeit der Qualitätssicherung in aller Regel kostenlos für die Verlage leisten) die Nutzungsrechte durch ebenfalls staatlich finanzierte wissenschaftliche Bibliotheken teuer zurückkauft. Herkömmliche Vorstellungen von Warentausch - wissenschaftliche Leistung in Form eines Artikels gegen Geld - scheinen im Wissenschaftsbetrieb auf den Kopf gestellt zu sein. 6

abtritt und nach dem Peer-Review-Verfahren (bei dem wiederum Reviewer aus dem Wissenschaftsbetrieb die Hauptarbeit der Qualitätssicherung in aller Regel kostenlos für die Verlage leisten) die Nutzungsrechte durch ebenfalls staatlich finanzierte wissenschaftliche Bibliotheken teuer zurückkauft. Herkömmliche Vorstellungen von Warentausch - wissenschaftliche Leistung in Form eines Artikels gegen Geld - scheinen im Wissenschaftsbetrieb auf den Kopf gestellt zu sein. 6

Debatte zur Selbstpublikation

Preprint-Server und Self-Archiving

Seit ca. zehn Jahren gibt es vor allem in der Physik, Mathematik und Informatik eine lebendige Preprint-Server-Szene. Ihre Vertreter plädieren für die freie Veröffentlichung der wissenschaftlichen Artikel im Web, noch bevor diese bei wissenschaftlichen Zeitschriften eingereicht werden, um dort ein Peer-Review Verfahren zu durchlaufen. Das soll jedoch keinem Ende des Peer-Reviews oder überhaupt der Veröffentlichung in wissenschaftlichen Zeitschriften das Wort reden. Die meisten auf Preprint-Servern veröffentlichten Artikel werden innerhalb der Frist eines Jahres auch in Peer-Review Zeitschriften verlegt. Nach der Veröffentlichung des Journal-Artikels kann der Preprint-Artikel upgedated werden. Auch wer seinen in einer Zeitschrift veröffentlichten Artikel noch nicht auf einem Preprint-Server stehen hat, soll ihn nachträglich dort ablegen, ungeachtet dessen, was der Verlag sagt. 7

Dieses komplexe Feld der Wissenschaftspublikation, das neben ökonomischen auch forschungspolitische, bildungssoziologische und informationstechnologische Implikationen hat, wird von einigen herausragenden Einzelpersonen der Digital-Library-Szene, Verlags- und Agenturvertretern sowie Vertretern von Selbstpublikationsinitiativen wie SPARC oder OAI besetzt. In Deutschland spielt vor allem eine Gruppe von Vertretern und Entwicklern der Preprint-Server in der Mathematik und Physik eine wichtige Rolle.

Im folgenden soll herausgearbeitet werden, was die Gemeinsamkeiten und was die Unterschiede in den Argumentationen einzelner Vertreter der Self-Archiving Community sind, was als Belege herangeführt wird und wo die Lösungen gesehen werden. Dazu werden die Positionen und Argumentationen von Andrew Odlyzko, Stevan Harnad, Paul Ginsparg, William Arms und Martin Grötschel sowie von den Organisationen SPARC, BOAI und OAI näher beleuchtet. Als prominenter Vertreter der Verlagspositionen soll Arnoud de Kemp beispielhaft die Gegenpositionen verdeutlicht werden.

Andrew Odlyzko, Direktor des Digital Technology Center an der University of Minnesota, USA, ist überzeugt davon, dass durch rein elektronisches Publizieren wissenschaftliche Information bei gleicher Qualität zu einem deutlich niedrigeren Preis verbreitet und archiviert werden kann als im herkömmlichen Print-Verfahren. Er schätzt die mittleren Einnahmen von Verlagen auf 4000$ pro Artikel (bei eine Spanne von 2000 bis 8000$) in einer Printzeitschrift und geht von Kosten in der Höhe von nur noch 300$ bis 1000$ (7,5-25%) pro Artikel bei einer elektronischen Zeitschrift mit Peer-Review aus. Noch größere Einsparungen wären seiner Meinung nach bei elektronischen Publikationsformen möglich, die weitgehend auf eine Redaktionstätigkeit verzichten und nur eine einfache Moderation der eingesandten Artikel durchführen, wie z.B. bei dem bekannten Preprint-Server von Paul Ginsparg (s.u.). Die Kosten reduzierten sich dort selbst bei großzügiger Veranschlagung von Personalaufwand (Betrieb, Softwareentwicklung) und Sachmitteln (Hardware, Internetzugang) auf etwa 75$ pro Artikel, was einen Bruchteil von 2% der Kosten von gedruckten Peer-Review-Publikationen ausmacht.

Odlyzko spricht lieber von einer Bibliothekskostenkrise als von einer Zeitschriftenkrise. Bedeutender als die Einsparmöglichkeit beim Übergang von Printpublikationen auf elektronische Publikationsformen im Bereich der Verlagstätigkeiten sind laut Odlyzko nämlich die Einsparmöglichkeiten im Bereich der Archivierung von Information, also in dem Bereich, in dem traditionell Bibliotheken tätig sind. Während die Kosten pro Printartikel bei mittleren 4000$ liegen, fallen durch den Aufbau und Betrieb von Bibliotheken ca. 8000$ pro abonnierten Artikel an. Selbst wenn die Wissenschaftsverlage alle ihre Zeitschriften kostenlos abgeben würden, fielen diese 8000$ pro Artikel an. Odlyzko ist klar, dass diese Kosten nur einen Teil der Gesamtkosten des wissenschaftlichen Publizierens darstellen: Es entstehen zusätzliche Kosten beim Forschen (20.000$), beim Redaktionsprozess (4000$) und sogar beim Nutzer (in der Höhe der Kosten der dafür eingesetzten Arbeitszeit).

Odlyzko beklagt des weiteren, dass beim wissenschaftlichen Publizieren nur eine geringe Korrelation zwischen dem Preis einer Zeitschrift und ihrer Qualität besteht, und dies selbst dann, wenn der Faktor Prestige in Betracht gezogen wird. Dies liegt seiner Meinung nach vor allem an dem ineffizienten Markt bzw. dem ungenügenden Wettbewerb in diesem Segment der Wissensindustrie.

Den Grund, warum es im wissenschaftlichen Publikationswesen zu keinem effizienten Wettbewerb kommt sieht Odlyzko auch in den "perversen" Anreizstrukturen begründet, die im wissenschaftlichen Publikationswesen vorherrschen:

- Der Nutzer (Wissenschaftler) nimmt Einfluss auf die Kaufentscheidung der Bibliothek, ohne jedoch aus seiner eigenen Tasche zu bezahlen. Selbst wenn er von der Bibliothek Zeitschriftenabonnements mit hohem Prestige aber schlechtem Preisleistungsverhältnis erwartet, verhält er sich noch ökonomisch rational, da diese Kosten nicht von seinem Konto abgehen.

- Autoren (Wissenschaftler) werden auch weiterhin in Zeitschriften publizieren, ungeachtet ihres Verbreitungsgrades (den sie meist nicht genau kennen) und besonders dann, wenn eine Zeitschrift ein hohes Prestige besitzt, weil dieses Prestige das ist, was zählt, für den beruflichem Erfolg im Wissenschaftsbetrieb (Berufungsverfahren etc.).

Trotzdem sollte es nach Meinung von Odlyzko möglich sein, durch den langsamen Übergang von Printpublizieren auf Elektronisches Publizieren, das Einsparpotential im Verlagswesen und bei Bibliotheken auszunutzen. Die Einsparungen sind allerdings nur möglich, wenn auf ein Nebeneinander von Printpublizieren und elektronischem Publizieren verzichtet wird und "electronic only" Publikation sich durchsetzt. Der Übergang wird auch nach Meinung von Odlyzko eher langsam vonstatten gehen. Freie oder preiswerte Preprints und elektronische Zeitschriften werden zwar zunehmen, aber lange Zeit werden die elektronischen Zeitschriften noch als Zusätze zu den Printversionen verbreitet werden und deshalb genauso teuer sein. (Odlyzko 1997)

Es wäre nach Meinung von Odlyzko zwar prinzipiell möglich, dass Bibliotheken die Aufgaben von Verlagen übernehmen, den umgekehrten Fall hält er jedoch aus kulturellen, ökonomischen, technologischen und juristischen Gründen für wahrscheinlicher. Ihre Profite könnten sie nur halten oder sogar vergrößern, wenn sie viele Funktionen der Bibliotheken übernehmen und dies könnten sie wiederum nur im Bereich der Digitalen Bibliotheken. (Odlyzko 1999)

Stevan Harnard arbeitet am Department of Electronics and Computer Science der University of Southampton, UK. Er ist zusammen mit Andrew Odlyzko sicher einer der profiliertesten Vertreter der internationalen Self-Archiving Community und hat in den letzten 10 Jahren über 30 Artikel zur Zeitschriftenkrise publiziert. In diesem Zusammenhang spricht er pointiert von der "Geiselnahme der Referee-Forschung" durch die Zugangshürden aufgrund der Kostenpflichtigkeit der wissenschaftlichen Zeitungsartikel:

In the online-era there is no longer any necessity, hence no longer any justification whatsoever, for continuing to hold the refereed research hostage to S/L/P 8 tolls and whatever add-ons they happen to pay for.

tolls and whatever add-ons they happen to pay for.

(Harnad 1998a)

Harnad unterscheidet in seiner Argumentation streng zwischen dem großen Sektor der "non-give-away literature", bei der Autoren ein Entgeld für ihre Publikation erwarten (fast alle Bücher, Zeitungen und Magazine), und dem vergleichsweise kleinen Sektor der "give-away literature", die die Autoren auch ohne Entgeld verbreiten möchten (Forschungsartikel in Referee-Zeitschriften), lediglich mit dem Ziel eines größtmöglichen "impacts" vor Augen. Die Vision von Harnad ist es nun, den letzteren Bereich der wissenschaftlichen Zeitschriftenpublikationen aus der oben genannten "Geiselnahme" zu "befreien", indem die Wissenschaftler dazu übergehen, ihre Publikationen selbst auf Preprint-Servern, oder im Rahmen der Open Archive Initiative, etc. zu archivieren ("self-archiving"). Er legt Wert auf den Begriff des "self-archiving" im Unterschied zu dem des "self-publishing", um auszudrücken, dass ein Unterschied besteht zwischen Publizieren (d.h. Durchlaufen eines Peer-Review Prozesses) und dem Archivieren von Peer-Review Artikeln. 9 Die Rolle der Verlage sieht Harnad über kurz oder lang weitgehend darauf reduziert, die Qualitätskontrolle in Form des Peer-Review zu organisieren. Da Verlage das Peer Review jedoch nicht selbst durchführen, - das wird, wie der Begriff ja schon andeutet, von den Peers, d.h. den Fachkollegen gemacht (zumeist kostenlos) - sondern nur organisieren würde, entspräche diese Leistung nur noch 10 bis 20% dessen, was Bibliotheken heute an die Verlage bezahlen. Es bliebe den Verlagen nichts anderes übrig, als sich anzupassen und zu verkleinern. Für darüber hinausgehende Forderungen der Verlage müsste es dann erst eine Entsprechung in zusätzlichen Leistungen geben, die über die Essenz der Qualitätskontrolle hinausginge. (Harnad 1995; Harnad 1998a; Harnad 1998b; Harnad 1999; Harnad, Varian et al. 2000a; Harnad 2000b; Harnad 2001a; Harnad 2001b; Harnad 2001c)

Die Rolle der Verlage sieht Harnad über kurz oder lang weitgehend darauf reduziert, die Qualitätskontrolle in Form des Peer-Review zu organisieren. Da Verlage das Peer Review jedoch nicht selbst durchführen, - das wird, wie der Begriff ja schon andeutet, von den Peers, d.h. den Fachkollegen gemacht (zumeist kostenlos) - sondern nur organisieren würde, entspräche diese Leistung nur noch 10 bis 20% dessen, was Bibliotheken heute an die Verlage bezahlen. Es bliebe den Verlagen nichts anderes übrig, als sich anzupassen und zu verkleinern. Für darüber hinausgehende Forderungen der Verlage müsste es dann erst eine Entsprechung in zusätzlichen Leistungen geben, die über die Essenz der Qualitätskontrolle hinausginge. (Harnad 1995; Harnad 1998a; Harnad 1998b; Harnad 1999; Harnad, Varian et al. 2000a; Harnad 2000b; Harnad 2001a; Harnad 2001b; Harnad 2001c)

Der Physiker Paul Ginsparg gründete 1991 einen mathematischen Preprint-Server für theoretische Hochenergiephysik bei den Los Alamos Laboratories (LANL) in New Mexico. Der Server enthält heute mehr als 170.000 Artikel im Volltext aus allen Gebieten der Physik, der Mathematik, Informatik und anderen Fächern. Der heute unter dem Namen arXiv bekannte Server wird von 35.000 Nutzern täglich angesteuert und jährlich kommen ca. 30.000 Artikel hinzu. Er ist aus der wissenschaftlichen Arbeit in der Physik nicht mehr wegzudenken. Die meisten hier als Preprints geposteten Artikel erscheinen später in Fachzeitschriften, die mitunter sogar den Server verwenden, um den Referee Prozess zu organisieren. Für einige Gebiete der Physik - so meinte Paul Ginsparg schon 1996 - wären die elektronischen Online-Archive zu den ersten Mitteln der wissenschaftlichen Kommunikation geworden und hätten die konventionellen Zeitschriften vollkommen in dieser Rolle ersetzt. Eine wesentliche Steigerung seines Gebrauchwerts erfährt dieser Preprint Server neuerdings durch das 1999 gestartete Open Citation Project (OpCit) 10 , ein Reference Linking Projekt, das sämtliche in arXiv enthaltene Texte über die enthaltenen Literaturhinweise dicht miteinander verknüpft. Über die Zitatanalysesoftware Citbase 11

, ein Reference Linking Projekt, das sämtliche in arXiv enthaltene Texte über die enthaltenen Literaturhinweise dicht miteinander verknüpft. Über die Zitatanalysesoftware Citbase 11 wird z.B. ein zitatbasiertes Ranking von Suchergebnissen sowie die Ausgabe von Impact-Hinweise zu jedem Artikel ermöglicht.

wird z.B. ein zitatbasiertes Ranking von Suchergebnissen sowie die Ausgabe von Impact-Hinweise zu jedem Artikel ermöglicht.

Wenn Paul Ginsparg über das wissenschaftliche Publikationswesen schreibt, stellt er es als eine Bezuschussung (funding) der Verlagsunternehmen durch die Forschungsbibliotheken dar, von der es unwahrscheinlich ist, dass sie im elektronische Publikationswesen überleben wird. Die hohen Kosten bei der Verbreitung wissenschaftlicher Information gehören für ihn einer Zeit an, als Artikel noch schwer herzustellen, schwer zu verbreiten, schwer zu archivieren und schwer zu duplizieren waren. Es ist für ihn nur eine Frage der Zeit, bis der Übergang von gedruckter zur vollkommen elektronischer Verbreitung stattgefunden hat. Unter den vollkommen elektronischen Publikationen versteht Ginsparg solche, die nicht begrenzt sind auf die Abbildung früherer Printpublikationen sondern sämtliche Vorteile der elektronischen Medien nutzen. Andere Formen würden seiner Meinung nach nicht akzeptiert werden. Paul Ginsparg unterscheidet zwischen "trade publications", die von vornherein mit dem Ziel geschrieben würden, durch die Veröffentlichung einen direkten finanziellen Gegenwert zu erhalten und "scholarly publications", die geschrieben würden, um Forschungsinformationen zu kommunizieren und Forschungsreputation aufzubauen. Wenn nicht mal die Autoren der letzteren Gruppe erwarten, Geld damit zu machen, sieht Ginsparg nicht ein, warum irgendjemand Geld damit verdienen soll, except for a fair return on non-trivial 'value-added' they may provide; or except if, as was formerly the case in the paper-only era, the true costs of making our documents publicly available are sufficiently high, to require that they be sold for a fee. Die Einschränkungen, die Paul Ginsparg an dieser Stelle macht, nehmen den entsprechenden Argumentationsstrang der Verlage vorweg: Diese argumentieren mit den tatsächlich anfallenden Kosten und Kostensteigerungen und zählen auf, welche "real-values" zu dem von den Autoren abgelieferten Informationsprodukt hinzugefügt werden (s.u.). (Ginsparg 1996; Ginsparg 1997)

William Arms, Professor für Computer Science an der Cornell University, USA und Editor-in-chief des D-Lib Magazine widerspricht heftig der Vorstellung, dass über kurz oder lang qualitativ hochwertige und darum wertvolle wissenschaftliche Information nur noch gegen Bezahlung und mit Zugriffskontrollsystemen im Web verbreitet werden. Diese Vorstellung käme, so schreibt er, von einem "commercial mindset" und sei "vollkommen falsch". Als Gegenargument führt er zahlreiche Beispiele auf, wo auch heute schon - und in Zukunft eher noch mehr - hochwertige Informationen im Web frei zugänglich sind. Auch die Volltexte, die Websuchmaschinen verzeichnen, sind seiner Meinung nach zwar oft wertlose Webseiten, aber darunter gäbe es durchaus auch solche von einer Qualität, die kommerziellen Diensten in nichts nachstehen.

Stärker als Odlyzko betont Arms daher Selbstpublikationsformen im Web, die ohne Peer-Review auskommen. Dazu gehören z.B. das gesamte Web als "digital library", die Preprint Archive, die nur geringe Moderationstätigkeiten ausüben oder die RFC Serien 12 . Auch die Verwertungsformen, die mit kommerziellen Suchmaschinen wie Google oder Portalen wie Yahoo Zugriff auf Volltexte im Web erleichtern, indem dieses automatisch indexiert wird, gehören für ihn zu den interessanten Open Access Systemen. (Arms 2000c)

. Auch die Verwertungsformen, die mit kommerziellen Suchmaschinen wie Google oder Portalen wie Yahoo Zugriff auf Volltexte im Web erleichtern, indem dieses automatisch indexiert wird, gehören für ihn zu den interessanten Open Access Systemen. (Arms 2000c)

Er ist sich darüber im klaren, dass elektronische Publikationsformen keineswegs kostenlos hergestellt werden. Vielmehr entstehen hier Fixkosten (first copy costs), in ähnlicher Höhe wie bei einer Printzeitschrift sowie nutzungsabhängige Kosten (Grenzkosten), die bei großen Webseiten auch beträchtliche Summen verschlingen können, jedoch letztlich immer noch vergleichsweise gering sind. In der Summe geht Arms ähnlich wie Odlyzko von einem beträchtlichen Einsparpotential aus. (Arms 1997; Arms 2000a; Arms 2000b; Arms 2000c; Arms 2000d)

Martin Grötschel, ehemaliger Vorsitzender der Deutschen Mathematischen Vereinigung (DMV) und Mitbegründer des überaus erfolgreichen MathNet Projekts hatte bereits zu Beginn der 90er Jahre, also noch vor dem großen Erfolg der Preprint Server vorgeschlagen, mit Hilfe der elektronischen Verbreitung von wissenschaftlicher Information das wissenschaftliche Publizieren in der Mathematik zu revolutionieren. Das Referate-Organ "Zentralblatt der Mathematik" könne bei gleichbleibenden Einnahmen des Verlags statt herkömmlich per Printvertrieb verbreitet zu werden, auf CDROM gebrannt und für einen Bruchteil des damaligen Preises an einen um ein Vielfaches größeren Abnehmerkreis verkauft werden. Die mit dem Zentralblatt assoziierte und beim Fachinformationszentrum Karlsruhe aufgelegte Datenbank MATH, die dort angeblich nur Kosten und keine Gewinne verursachte, könne genauso gut von der Deutschen Mathematischen Vereinigung (DMV) übernommen werden und bei einem mathematischen Institut oder einer größeren Forschungseinrichtung zu geringen Kosten aufgelegt werden. Der Zugriff dort solle aber kostenlos sein. (Grötschel, Luegger et al. 1993, S. 28) Durch solche und ähnliche Initiativen könne der hohe technische und organisatorische Aufwand, die kostenpflichtige Verbreitung von wissenschaftlicher Information durch komplexe Kontrollmechanismen und Abrechnungsverfahren vermieden werden. Grötschel erhob 1999 in einem Interview auch schwere Vorwürfe gegen die Forschungspolitik der Bundesregierung: Im Unterschied zu der Fördermaßnahme Global Info, an der die kommerziellen Verlage beteiligt sind, sei das Projekt MathNet, das neben Informationen zu Institutionen, Personen, Forschungsprojekten eben auch Preprint Server integriert, von der Bundesregierung nicht gefördert worden. Mit Global Info habe der Forschungsminister die Interessen der Verlage unterstützt.

Ein weiteres wichtiges Anliegen für Grötschel ist das Veröffentlichen der wissenschaftlichen Primärinformationen und das Bereitstellen von Multimedia Daten. Deswegen plädiert er dafür die Dokumentenmodelle der Preprint-Server entsprechend zu erweitern.

Scholarly Publishing and Academic Ressources Coalition (SPARC)

Mit drastischen Worten beschreibt die im Jahr 1998 gegründete Scholarly Publishing and Academic Ressources Coalition (SPARC) die Zeitschriftenkrise:

A few commercial publishers discovered that the easiest way to increase profits was to raise subscription prices and, moreover, that the fattest profits came from raising library subscription prices aggressively and relentlessly. Institutional subscribers, accounting for the lion's share of the revenue supporting publication of journals in most fields, paid the price - reluctantly and with increasing difficulty - because their users demanded access. With this foot in the door, these few commercial publishers built substantial portfolios of journals, aided by the trend of scholarly societies out-sourcing their journals to commercial firms. The high profits from these journals have funded wave upon wave of acquisitions and consolidations among publishers, and often these profits are diverted out of scientific activities into unrelated lines of business in order to enhance shareholder value.

(SPARC 2000)

Trotz dieser deutlichen Worte geht es SPARC nicht unbedingt um freien Zugang zu wissenschaftlicher Information sondern lediglich um "vernünftige" und "faire" Preisgestaltung sowie darum, dass die Abonnenten der Zeitschriften auch den richtigen Gegenwert für ihr Geld erhalten. SPARC sieht die Ursachen für die exorbitant hohen Preissteigerungen des wissenschaftlichen Zeitschriftenmarktes vor allem in dem zu geringen Wettbewerb und der zu geringen Nachfrageelastizität. Ihr Ziel ist es daher, durch die Unterstützung der Neugründung von qualitativ hochwertigen non-profit oder low-cost Journalen in direkter Konkurrenz zu hochpreisigen, etablierten Zeitschriftentiteln, genau diesen Wettbewerb herbeizuführen. Mit diesen neuen niedrigpreisigen oder gar kostenlosen non-profit-Zeitschriften sollen Alternativen geschaffen werden, die die traditionellen Journale entweder ersetzen können oder doch die Verlage dieser Zeitschriften zumindest dazu zwingen, ihre Preise dem schärferen Wettbewerb anzupassen - entweder durch Preisreduktion oder wenigstens durch moderatere Preissteigerungen. SPARC arbeitet zu diesem Zweck zusammen mit wissenschaftlichen Fachgesellschaften, Universitätsverlagen und unabhängigen Verlagen, macht Öffentlichkeitsarbeit und beteiligt sich an anderen Inititativen der Self-Archiving Community (OAI, BOAI). Heute hat die SPARC Initiative etwa 200 Mitgliedsorganisationen, die mit Mitgliedsbeiträgen (gestaffelt je nach Größe der Einrichtung oder Fachgesellschaft) und sogenannten "Purchasing Commitments" neue Zeitschriften unterstützen und für eine schnelle Verbreitung und Akzeptanz der neuen Titel sorgen. Interessant ist auch die "Declaring Independance" Initiative von SPARC, die darauf abhebt, dass die editorial boards in Preisverhandlungen mit ihren Verlegern treten und versuchen eine andere Preispolitik zu erreichen. Im Fall des American Journal of Physical Anthropology führte dies zu einer Preissenkung um mehr als 30%. In zwei andere Fällen (Evolutionary Ecology und Journal of Logic Programming) kam es zu einem geschlossenen Rücktritt der editorial boards und der Neugründung von Alternativzeitschriften ("Evolutionary Ecology Research" und "Theory and Practice of Logic Programming") mit Starthilfe von SPARC. In kurzer Zeit konnten diese, die Position der ursprünglichen Journale einnehmen und ein Äquivalent schaffen; das es den Abonnenten erlaubt die ursprünglichen Zeitschriften abzubestellen und durch die neuen niedrigpreisigen Zeitschriften gleicher Qualität zu ersetzen. Die SPARC Initiative experimentiert ferner mit electronic-only Zeitschriften, weiteren Digital Library Projekten für wissenschaftliche Fachgesellschaften und neuen Businessmodellen (z.B. reine author-charges oder Preisdifferenzierung bei elektronischen Versionen unterschiedlicher Qualität der gleichen Zeitschrift). (SPARC 2000; Case 2002)

Open Archives Initiative (OAI)

Im Oktober 1999 fand ein Treffen der in der Preprint-Community aktiven Wissenschaftler in Santa Fe statt, bei dem es darum ging, die Möglichkeiten einer verstärkten Zusammenarbeit zu untersuchen, die geeignet sind, Preprint Lösungen zu einer besseren Verbreitung zu führen. Das Ergebnis dieses Treffens war die Gründung einer sogenannten Open Archives Initiative OAI) und wurde in der sogenannten Santa Fe Convention festgehalten. "Open" meint die offengelegten Schnittstellenstandards, die es verschiedensten Inhaltsanbietern gestattet, ihren Content anzubieten. In kurzer Zeit wurde in diesem Rahmen ein Vorschlag für eine Interoperabilitätsplattform ausgearbeitetet, die in der Lage sein sollte, sämtliche als Eprints veröffentlichten wissenschaftlichen Zeitschriftenartikel weltweit zu verzeichnen und die Metadaten (URL, Titel, Autor, Datum, Schlagworte, etc.) langfristig vorzuhalten und suchbar zumachen. Aufgrund der denkbar einfachen Funktionsweise sollten die Einstiegshürden minimiert werden und auf diese Weise die Implemetierung von OAI-konformen Servern eine schnelle Verbreitung finden. Technisch handelte es sich um ein Metadatenaustausch-Protokoll, das ein Subset des älteren Dienst-Protokolls war.

Seitdem hat sich herausgestellt, dass dieser erste Vorschlag zu kurz gegriffen hatte. Nicht alle interessierten Gruppen - z.B. solche außerhalb des kleinen Kreises der Preprint-Server Community wie Museen und Archive - konnten ihn nutzen und so wurde im Juni 2002 ein zweiter verbesserter Vorschlag unterbreitet, der eine größere Flexibilität und breitere Anwendbarkeit verspricht. Er basiert auf dem http-Protokoll, nutzt XML als Austauschformat und enthält Empfehlungen für den Einsatz eines gemeinsamen Metadaten Sets auf Basis des Dublin Core Metadaten-Standards. Zeitgleich wurden Applikationen entwickelt, die den einfachen Austausch dieser Metadaten durch die Inhaltsanbieter ermöglichte. Nur über diese Metadaten wird der weltweite Content an wissenschaftlichen Zeitschriften später suchbar sein - eine Volltextsuche ist bisher nicht enthalten.

Die Qualitätssicherung der im OAI - Index verzeichneten Inhalte ist als eine Art Selbstkontrolle der Wissenschaftler gedacht: sie soll dezentral bei den Instituten stattfinden, die ihre Inhalte über OAI-Server zur Verfügung stellen. Die dafür verwendete OAI-Implementierung namens EPrints 13 stellt für diese Zwecke Redaktions- und Moderationsfunktionen zur Verfügung. Allerdings war schon bei der ersten Version des OAI-Protokolls eine Client-Software namens Kepler 14

stellt für diese Zwecke Redaktions- und Moderationsfunktionen zur Verfügung. Allerdings war schon bei der ersten Version des OAI-Protokolls eine Client-Software namens Kepler 14 bereitgestellt worden, die es erlaubte, die Inhalte von kleinsten, von Einzelpersonen betriebenen OAI Archiven einzuspeisen, womit eine wie auch immer geartete Qualitätskontrolle natürlich ausgehebelt wäre. (Maly, Zubair et al. 2001)

bereitgestellt worden, die es erlaubte, die Inhalte von kleinsten, von Einzelpersonen betriebenen OAI Archiven einzuspeisen, womit eine wie auch immer geartete Qualitätskontrolle natürlich ausgehebelt wäre. (Maly, Zubair et al. 2001)

In Deutschland wurde die OAI bisher insbesondere von der Deutschen Initiative für Netzwerk Information (DINI) und den DFG-finanzierten Virtuellen Fachbibliotheken 15 aufgegriffen. DINI fordert alle deutschen Hochschulen dazu auf, sich an der Open Archive Initiative zu beteiligen und ihre Server für wissenschaftlichen Publikationen mit OAI konformen Schnittstellen zu versehen. Ferner empfehlen sie den Einrichtungen der Forschungsförderung in Deutschland, die Einhaltung der OAI-Spezifikationen zur Voraussetzung bei der Bewilligung von Förderanträgen zu machen. (vgl. (DINI 2000))

aufgegriffen. DINI fordert alle deutschen Hochschulen dazu auf, sich an der Open Archive Initiative zu beteiligen und ihre Server für wissenschaftlichen Publikationen mit OAI konformen Schnittstellen zu versehen. Ferner empfehlen sie den Einrichtungen der Forschungsförderung in Deutschland, die Einhaltung der OAI-Spezifikationen zur Voraussetzung bei der Bewilligung von Förderanträgen zu machen. (vgl. (DINI 2000))

Die OAI, die ihre Wurzeln in der Preprint Community hat, hat sich in der Zwischenzeit also erheblich erweitert. Sogar Verlage, die eigentlich von den Initiatoren der OAI als die (Mit-)Verursacher für die Zeitschriftenkrise angesehen werden, können sich beteiligen. Es wären somit später Szenarios denkbar, bei denen Verlagsinhalte und freie Inhalte im selben Index nebeneinander stehen, oder aber auch nur Verlagsinhalte auffindbar sind, für die evtl. ein bestimmter Preis verlangt wird, bevor sie abrufbar sind.

Wichtige Wortführer der Self-Archiving Community sprechen sich für die OAI aus und empfehlen sie als eine praktische Handlungsanleitung für Fachgesellschaften und Bibliotheken, um langfristig einen Ausweg aus der Zeitschriftenkrise zu finden. Die OAI selbst argumentiert jedoch mehr mit technischen Konzepten als mit ökonomischen Begriffen. Es geht um technische Schnittstellen zwischen Informationssystemen, Metadatenstandards und Client-Serversoftware. (DINI 2000; Sompel and Lagoze 2000)

Budapester Open Access Initiative (BOAI)

Während SPARC den Schwerpunkt ihrer Aktivitäten auf die Schaffung eines weniger monopolistisch strukturierten Marktes für wissenschaftliche Zeitschriften legt, möchte die Budapester Open Access Initiative 16 vor allem den freien Zugang zu wissenschaftlichen Zeitschriften fördern. Ihre Hauptstossrichtungen sind daher die Verbreitung der Philosophie des open access und die konkrete Unterstützungen desselben in Form von Anschubfinanzierungen für Self-Archiving Initiativen und Open-Access Fachzeitschriften. Unter "Open Access" wird der kostenlose und unbeschränkte Zugang zu wissenschaftlicher Information verstanden. Das Internet wird als ein Medium begriffen, dass die Möglichkeit schafft, Information weltweit elektronisch zu verbreiten. Die Folgen wären laut BOAI eine Beschleunigung von Forschung, verbesserte Bildungsmöglichkeiten und ein wechselseitiges Lernen der 'Armen' von/mit den 'Reichen' und der 'Reichen' von/mit den 'Armen'.. Die erhöhte Verbreitung wissenschaftlicher Literatur würde nicht nur zu einer wesentlich größeren und nachweisbaren Sichtbarkeit, Leserschaft und Bedeutung der Autoren führen sondern auch dazu beitragen, Grundlagen für den Austausch und das Verstehen auf der Basis eines geteilten Wissens zu legen, die weit über die Wissenschaften hinaus bedeutsam und wirksam sein werden. Hinsichtlich des Copyrights und der Weiterverwendung der frei zugänglich gemachten wissenschaftlichen Arbeiten sieht BOAI ein an die Lizenzmodelle der Freien Software Bewegung erinnerndes Modell vor: Die wissenschaftlichen Volltexte sollen auf "jede denkbare legale Weise" nutzbar sein, den Autoren soll aber die Kontrolle über ihre Arbeit belassen werden und das Recht auf eine angemessene Anerkennung und Zitierung gesichert werden. Zu den Beispielen der möglichen Finanzierungsformen für Open Access Zeitschriften werden allerdings neben Spenden, privaten oder staatlichen Fördermitteln auch Einnahmen aus Werbe-Add-ons in den Texten genannt. (BOAI 2002). Einer kommerziellen Verwertung der Open Access-Projekte scheint nichts mehr im Wege zu stehen.

vor allem den freien Zugang zu wissenschaftlichen Zeitschriften fördern. Ihre Hauptstossrichtungen sind daher die Verbreitung der Philosophie des open access und die konkrete Unterstützungen desselben in Form von Anschubfinanzierungen für Self-Archiving Initiativen und Open-Access Fachzeitschriften. Unter "Open Access" wird der kostenlose und unbeschränkte Zugang zu wissenschaftlicher Information verstanden. Das Internet wird als ein Medium begriffen, dass die Möglichkeit schafft, Information weltweit elektronisch zu verbreiten. Die Folgen wären laut BOAI eine Beschleunigung von Forschung, verbesserte Bildungsmöglichkeiten und ein wechselseitiges Lernen der 'Armen' von/mit den 'Reichen' und der 'Reichen' von/mit den 'Armen'.. Die erhöhte Verbreitung wissenschaftlicher Literatur würde nicht nur zu einer wesentlich größeren und nachweisbaren Sichtbarkeit, Leserschaft und Bedeutung der Autoren führen sondern auch dazu beitragen, Grundlagen für den Austausch und das Verstehen auf der Basis eines geteilten Wissens zu legen, die weit über die Wissenschaften hinaus bedeutsam und wirksam sein werden. Hinsichtlich des Copyrights und der Weiterverwendung der frei zugänglich gemachten wissenschaftlichen Arbeiten sieht BOAI ein an die Lizenzmodelle der Freien Software Bewegung erinnerndes Modell vor: Die wissenschaftlichen Volltexte sollen auf "jede denkbare legale Weise" nutzbar sein, den Autoren soll aber die Kontrolle über ihre Arbeit belassen werden und das Recht auf eine angemessene Anerkennung und Zitierung gesichert werden. Zu den Beispielen der möglichen Finanzierungsformen für Open Access Zeitschriften werden allerdings neben Spenden, privaten oder staatlichen Fördermitteln auch Einnahmen aus Werbe-Add-ons in den Texten genannt. (BOAI 2002). Einer kommerziellen Verwertung der Open Access-Projekte scheint nichts mehr im Wege zu stehen.

In einem sogenannten "Information Programm" verpflichtete sich die Trägerorganisation OSI, eine 1993 von George Soros gegründete private Stiftung, ab Februar 2002 für die Dauer von drei Jahren jährlich 1 Mio US$ für Open Access Projekte zu vergeben.

Public Library of Science (PloS)

Die mittlerweile 30.000 Wissenschaftler aus aller Welt, die den offenen Brief der PloS unterzeichnen, glauben,

that the permanent, archival record of scientific research and ideas should neither be owned nor controlled by publishers, but should belong to the public, and should be freely available through an international online public library. 17

Um dies zu erreichen, gehen sie den Weg eines Autoren, Editoren, Reviewer und individuellen Abonnementsboykotts. Sie geloben, dass

[they] will publish in, edit or review for, and personally subscribe to, only those scholarly and scientific journals that have agreed to grant unrestricted free distribution rights to any and all original research reports that they have published, (...) within 6 months of their initial publication date.

Den Verlagen wird also ein Verwertungszeitraum von maximal 6 Monaten zugestanden; danach wollen die Wissenschaftler ihren Artikel ohne Zugriffsbeschränkungen zugänglich machen. Laut Meier 2002 erfüllten bis August 2001 ganze 89 Zeitschriften die Bedingungen der PloS.

Die Idee der frei zugänglichen Zweitveröffentlichung nach einer Verwertungsfrist von mehreren Monaten soll einen Kompromiss darstellen zwischen dem Interesse der Wissenschaft auf möglich freien Zugriff auf publizierte Forschungsergebnisse und dem Interesse der kommerziellen und nichtkommerziellen Verlage an einer "fairen" Verwertung. Sie basiert letztendlich auf dem Wissen um den relativ raschen Relevanzverlust von nicht mehr ganz so aktuellen Artikeln für die Wissenschaft. Auch wenn die Nachfrage nach Artikeln in Abhängigkeit der Zeit von Fach zu Fach sehr unterschiedlich ausfallen kann 18 , jedoch grundsätzlich dazu führt, dass nach einem Jahr mehr als 60% der Artikelzugriffe statt gefunden haben und nach 3 Jahren über 75%. (vgl. Tab. / Bild)

, jedoch grundsätzlich dazu führt, dass nach einem Jahr mehr als 60% der Artikelzugriffe statt gefunden haben und nach 3 Jahren über 75%. (vgl. Tab. / Bild)

Odlyzko (s.o.) hält nichts davon, den Verlagen derartige Zugeständnisse zu machen. Er hat diesen Appell nicht unterschrieben, wenngleich er davon ausgeht, dass auch (Tenopir and King 2002) dies ein Schritt in die richtige Richtung wäre. Allerdings geht ihm der Ansatz nicht weit genug und er setzt stattdessen auf den Aufbau von kostenlosen Preprint-Servern, freien elektronischen Peer-Review-Zeitschriften oder die Open Archives Initiative.

| Alter des gelesenen Artikels (Anzahl Jahre seit der Veröffentlichung) | universitäre Wissenschaftler | ausseruniversitäre Wissenschaftler |

| 1 | 58.5% | 66.9% |

| 2 | 12.3% | 15.1% |

| 3 | 6.2% | 1.7% |

| 4-5 | 7.7% | 5.2% |

| 6-10 | 9.3% | 2.9% |

| 11-15 | 1.5% | 2.9% |

| over 15 | 4.6% | 5.2% |

Verlagsreaktionen

Die Verlagsreaktionen auf die diversen Vorstöße der Self Archiving und Open Access Commuity waren sehr unterschiedlich. Ein häufige Reaktion war und ist die Abwehr der Unterstellungen der maßlosen Bereicherungen und der Profitmacherei auf Kosten der Wissenschaft durch Betonung der steigenden Qualität, des gestiegenen Umfangs und der gestiegenen Produktionskosten der Journale sowie der zusätzlichen Investitionen im Online Publishing. Es wird argumentiert, daß die Verlage eine wichtige, unverzichtbare Funktion für die Qualitätssicherung im Peer-Review-Verfahren hätten und darauf verwiesen daß Journale von Fachgesellschaften ähnliche Preissteigerungen zeitigen wie die kommerziellen Verlage. Eine andere Strategie war das Nichtakzeptieren der auf Preprint-Servern vorveröffentlichten Artikel für die Veröffentlichung in einer Zeitschrift oder das Einbehalten aller Rechte der Publikation - auch der elektronischen - wodurch eine Zweitveröffentlichung z.B. auf einem Uni-Server untersagt werden kann. Sehr verbreitet ist heutzutage auch das Bundling, d.h. der Verkauf von elektronischer und Printausgabe als Paket, teilweise mit bis zu 10% Aufschlag für die elektronische Version. Es ist dann meist nicht möglich eine elektronische Version alleine zu beziehen und wenn doch, dann nur zu einem geringfügig (um 10%) reduzierten Preis gegenüber dem Printabonnement.

Arnoud de Kemp, Bereichsleiter für Marketing, Sales und Corporate Development im Springer Verlag, rechtfertig die jährlichen Preissteigerungen von derzeit etwa 10% mit gestiegenen Verlagskosten aufgrund von höheren Redaktionsvergütungen, Investitionen in neue Technologien, zusätzlichen Aufwand beim Marketing, Verkauf und Vertrieb. Des weiteren würden die Abonnentenzahlen bei allen Verlagen jährlich um etwa 8 bis 10% sinken, was sich nur durch Preiserhöhungen auffangen ließe. Einsparungen im Printbereich durch den Verkauf von Electronic Only Zeitschriften gibt de Kemp deswegen kaum eine Chance, weil es immer noch Bibliotheken und Autoren gibt, die auf die gedruckte Version nicht verzichten wollen. Die SPARC Initiative hielt de Kemp zumindest Anfang 2000 nicht für besonders erfolgreich, zumal sie bis dahin nur einige wenige Zeitschriften gegründet habe. (Sietmann 2000)

Zu den neueren Reaktionen gehört der Aufbau eigener Preprint Archive, basierend auf Artikeln die schon das Peer-Review durchlaufen haben aber noch auf den Druck warten oder das verstärkte Ausnutzen der technischen Möglichkeiten des elektronischen Mediums. Bereits heute werden die elektronischen Zeitschriften einiger kommerzieller Verlage per Reference-Linking mit anderen elektronischen Zeitschriften des gleichen Verlags verlinkt. Geplant und in Ansätzen bereits eingeführt ist eine Kooperation zwischen mehreren kommerziellen Verlagen, die die Integration ihrer Online-Zeitschriften durch Verlinkung auch über Verlagsgrenzen hinweg beabsichtigen. 19 Ein wichtige Rolle spielt in diesem Zusammenhang auch die DOI Initiative 20

Ein wichtige Rolle spielt in diesem Zusammenhang auch die DOI Initiative 20 , bei der über weltweit eindeutige Handles Dokumentadressen (Identifier) verwaltet und langfristig vorgehalten werden können, was wiederum das Zitieren elektronischer Dokumente erleichtert. Das DOI-System ist eng mit Konzepten zur Sicherung des Copyrights der Inhalteanbieter verbunden. Die Identifier bleiben fix, auch wenn sich die URL der so adressierte Dokumente ändert oder wenn die Dokumente den Eigentümer wechseln. Anders als bei dem Reference Linking Projekt OpCit (s.o.) führt ein DOI - Link nicht unbedingt zu einem Volltext sondern kann auch - je nach Zugriffsrecht - mit einem vorgeschalteten Bestellformular für ein Zeitschriftenabo oder einem Zahlungsdialog verbunden sein. (Rosenblatt 1997)

, bei der über weltweit eindeutige Handles Dokumentadressen (Identifier) verwaltet und langfristig vorgehalten werden können, was wiederum das Zitieren elektronischer Dokumente erleichtert. Das DOI-System ist eng mit Konzepten zur Sicherung des Copyrights der Inhalteanbieter verbunden. Die Identifier bleiben fix, auch wenn sich die URL der so adressierte Dokumente ändert oder wenn die Dokumente den Eigentümer wechseln. Anders als bei dem Reference Linking Projekt OpCit (s.o.) führt ein DOI - Link nicht unbedingt zu einem Volltext sondern kann auch - je nach Zugriffsrecht - mit einem vorgeschalteten Bestellformular für ein Zeitschriftenabo oder einem Zahlungsdialog verbunden sein. (Rosenblatt 1997)

Bezug zur Freien Software, Open Source und Open Content Bewegung

An dieser Stelle sollen kurz die verschiedenen Modelle von Freier Software, Open Source und Open Content rekapituliert werden um anschliessend Gemeinsamkeiten und Unterschiede untereinander und in Bezug auf Open Access Modelle herauszuarbeiten.

Freie Software beruht nach Aussage von Peter Gerwinski (Head of Office der Free Software Foundation Europe) auf den Konzepten der freien Modifizierbarkeit von Software, der Möglichkeit der Weitergabe (auch in modifizierter Form) und der freien Benutzbarkeit dieser Software für alle. Seit Mitte der 80er Jahre propagiert die Free Software Foundation (FSF) diese Konzepte der freien Softwareentwicklung und versucht so verbreitete Software auch lizenzrechtlich zu schützen. Freie Software wird unter verschiedenen Lizenzvarianten verbreitet: Die GNU General Public Licence (GNU GPL) 21 unterbindet, daß freie Software in nicht-freie Software umgewandelt werden kann oder daß freie Software durch Verlinkung mit nicht-freier Software kombiniert wird. Letzteres ist bei der Lesser General Public License (LGPL) erlaubt.

unterbindet, daß freie Software in nicht-freie Software umgewandelt werden kann oder daß freie Software durch Verlinkung mit nicht-freier Software kombiniert wird. Letzteres ist bei der Lesser General Public License (LGPL) erlaubt.

Open Source Software ist dagegen Software, bei der zwar der Quellcode einsehbar und veränderbar ist, jedoch die Vermischung mit kommerzieller Software geradezu erwünscht ist. Der Unterschied zwischen Open Source Software und Freier Software wird von der FSF Europe wie folgt auf den Punkt gebracht:

Selbstgewähltes Ziel der Open Source Bewegung ist es, ein Marketingprogramm für Freie Software darzustellen. Dies will sie durch gezielte Abkehr von den philosophischen und politischen Hintergrundüberlegungen tun, da diese als störend bei der Kommerzialisierung empfunden werden. Die Freie Software Bewegung hat hingegen in der Philosophie und den Hintergründen schon immer einen essentiellen Teil des Phänomens und eine wesentliche Stärke gesehen. 22

Eine nützliche Aufstellung zu den unterschiedlichen Kommerzialisierungsgraden von Verbreitungsmodellen von Softwarelizenzen ist bei Meretz (2000) zu finden.

| Lizenz-Eigenschaften Software-Art | Null-Preis | Freie Verteilung | Unbegrenzter Gebrauch | Quelltext vorhanden | Quelltext modifizierbar | Alle Ableitungen müssen frei sein | Keine Vermischung m. proprietärer SW |

| Kommerziell ('Microsoft') | |||||||

| Probe-Software, Shareware | (X) | X | |||||

| Freeware ('Pegasus-Mail') | X | X | X | ||||

| Lizenzfreie Libraries | X | X | X | X | |||

| Freie Software (BSD, NPL, ...) | X | X | X | X | X | ||

| Freie Software (GNU LGPL) | X | X | X | X | X | X | |

| Freie Software (GNU GPL) | X | X | X | X | X | X | X |

Wichtig ist hier festzuhalten, daß, trotz der Tatsache, daß selbst die als unkommerzieller angesehene Freie Software zumeist in freien Zusammenschlüssen produziert wird, sie

- auch im Rahmen von Lohnarbeit hergestellt

- in privatwirtschaftlichen Unternehmen genutzt sowie

- indirekt verwertet (z.B. Werbung, Support, Installation, Wartung, Schulung, Anpassung, Vertrieb von Distributionen)

werden kann. (Grassmuck 2000; FLOSS 2002)

Und selbst das in freier Kooperation erworbene Know How kann den Entwicklern Freier Software zu einem späteren Zeitpunkt beim Anbieten ihrer hochqualifizierten Arbeitskraft nützlich sein und sich somit quasi zeitverzögert verwerten lassen. Peter Gerwinski ist Recht zu geben, wenn er pointiert herausstellt, daß Freie Software eigentlich kommerzielle Software ist. 23

Die GNU Free Documentation License (GFDL) ist ein Versuch der Übertragung der GPL für Freie Software auf die mit der freien Software mitgelieferten Dokumentationen; sie kann aber auch für beliebige andere Textdokumente eingesetzt werden. Seit März 2000 liegt sie als Version 1.1 vor, ein Entwurf für die Version 1.2 wird derzeit diskutiert. 24 Die GFDL gestattet das Kopieren und Verbreiten, auch modifiziert, egal ob in kommerziellem oder nicht-kommerziellen Kontext. Ausführlich legt sie fest, in welcher Art Modifikationen eines Originaltextes gestaltet sein müssen (anderer Titel, Kennzeichnung unveränderter Teile, Abbildung der Änderungsgeschichte, Link auf den Ursprungstext und die Vorgängerversionen, etc.)

Die GFDL gestattet das Kopieren und Verbreiten, auch modifiziert, egal ob in kommerziellem oder nicht-kommerziellen Kontext. Ausführlich legt sie fest, in welcher Art Modifikationen eines Originaltextes gestaltet sein müssen (anderer Titel, Kennzeichnung unveränderter Teile, Abbildung der Änderungsgeschichte, Link auf den Ursprungstext und die Vorgängerversionen, etc.)

In der Open Content License (OPL) (Lizenzversion 1.0 vom Juli 1998 25 , einer weiteren Lizenz für freie Inhalte, wird festgeschrieben, daß Texte, die unter dieser Lizenz stehen

, einer weiteren Lizenz für freie Inhalte, wird festgeschrieben, daß Texte, die unter dieser Lizenz stehen

- in beliebigen Medien kopiert und

- nach Belieben abgeändert werden dürfen, vorausgesetzt, die Copyright- und Lizenzhinweise bleiben erhalten.

Jeder auf einem Text mit Open Content-Lizenz basierende neue Text (Erweiterungen / Kürzungen) steht dann automatisch wieder unter der OpenContent Lizenz. Für den Netzwerkzugriff auf den Text (via FTP, http etc.) darf keinerlei Gebühr verlangt werden. Es bleibt aber möglich, für darüber hinausgehende Dienste ("media and/or handling involved in creating a unique copy", "instructional support", "warranty") Gebühren zu verlangen. Ähnlich wie bei der freien Software gibt es auch hier die Grauzone der "resonable considered independant and seperate works" bei gemischten Texten. Der Einsatz der OpenContent Lizenz ist bei weitem nicht so weit verbreitet, wie der der diversen Lizenzvarianten der Freien Software.

Vielleicht nur so viel zur Rekapitulation von bestehenden Konzepten von Freien Lizenzmodellen.

Die inhaltliche Nähe zwischen den Ansätzen der OpenContent Bewegung und den Ansätzen der Self-Archiving Community ist allein schon erkennbar an den gegenseitigen Verweisen auf ihre jeweiligen Projekte. So präsentiert die Website www.opencontent.org als "Featured Content" den offenen Brief der Public Library of Science (PLoS) und fordert dazu auf, diese zu unterzeichnen und die Eprints Software wird mittlerweile als ein GNU Projekt präsentiert.

als "Featured Content" den offenen Brief der Public Library of Science (PLoS) und fordert dazu auf, diese zu unterzeichnen und die Eprints Software wird mittlerweile als ein GNU Projekt präsentiert.

Darüberhinaus lohnt es sich ein wenig tiefer zu gehen und die grundsätzlichen Gemeinsamkeiten und Unterschiede zwischen den Verbreitungsformen von Freier Software und Self-Archiving oder Open Access Projekten zu untersuchen.

Der Herstellungskontext von wissenschaftlicher Information unterscheidet sich natürlich an zahlreichen Punkten von dem bei der Entwicklung Freier Software. So spielt z.B. das Prestige oder die wissenschaftliche Reputation, die sich wesentlich auch über die Publikations- und Zitierweise definiert, sowie der berufsbedingte Veröffentlichungsdruck eine viel größere Rolle im Wissenschaftsbetrieb - der tatsächliche Gebrauchswert eines intellektuellen Produkts, der bei in der Freizeit entwickelten Freien Software im Zentrum steht, tritt hier in den Hintergrund.

Im bestehenden Wissenschaftsbetrieb hat sich zudem bereits eine relativ feststehende Praxis der Nutzung der wissenschaftlichen Produkte anderer etabliert, die klare Regeln für die "wissenschaftliche Zitierweise" oder die Nutzung der Arbeiten von Fachkollegen und Untergebenen beinhaltet. Es wäre z.B. unmöglich, einen längeren Artikel eines Fachkollegen mit kleinen Verbesserungen zu versehen und als neue Publikation bei einer wissenschaftlichen Zeitschrift einzureichen, es ist aber gang und gäbe, sich wissenschaftliche Ergebnisse von Mitarbeitern und Untergebenen anzueignen und unter seinem eigenen Namen zu veröffentlichen, bzw. als Koautor aufzutreten.

Zunächst mal ist aber festzuhalten, dass die Self Archiving und Open Access Community in erster Linie wissenschaftliche Artikel in Form von Texten oder Bildern verbreitet, wenngleich anderer, mit diesen Fachartikeln verbundener Content wie Labordaten, Audios, Videos, Software, etc. nicht mehr lange auf sich warten lassen wird. Ähnlich wie bei der Unterscheidung von Quelltext und Binärcode bei Software, gibt es bei Texten den Unterschied zwischen einfachen, nichtproprietären Formaten wie ASCII, RTF, TeX, etc., die mit einer Vielzahl freier Textverbeitungssysteme bearbeitet werden können und den proprietären Formaten wie Word, PDF oder eBook, deren Gebrauch (Ansicht, Bearbeitung, Ausdruck, Kopie) proprietäre Software (Textverarbeitung, Betriebssystem) erfordert. Der eBook Reader von Adobe ist eigentlich ein Digital Rights Management System, das z.B. kontrollieren kann, wie oft, welche Menge von Zitaten in welcher Zeit herauskopiert oder ausgedruckt werden kann

Ohne eine Open Content (oder eine vergleichbare) Lizenz für die Inhalte wäre der freie Zugang auf Open Access Ejournals lediglich vergleichbar mit einem offen gelegten Source Code, bei dem zwar der Code eingesehen aber nicht verändert oder modifiziert weiterverbreitet werden darf. Dies würde noch nicht mal die niedrigere Hürde der Open Source Kriterien nehmen können und entspräche vielleicht der Kategorie der lizenzfreien Libraries in Tabelle 4.

Analog zur Freien Software Bewegung, die über bestimmte Lizenzmodelle (GPL, LGPL, etc.) garantiert, dass der Source Code, der unter dieser Lizenz produziert wird, nicht privat angeeignet und das dort codierte Wissen der Öffentlichkeit entzogen werden kann, strebt die Self-Archiving Community nach langfristig freier Zugänglichkeit von wissenschaftlichen Zeitschriftenartikeln. Damit meinen sie Zugriffsbeschränkungen in Form von Abogebühren, Campusverträgen oder pay-per view. Dieser Begriff von freier Zugänglichkeit schliesst eine Verwertung z.B. über Werbebanners nicht aus. Sehr wohl soll jedoch eine kommerzielle Nutzung dritter ausgeschlossen sein (vgl. Copyright Hinweis des D-Lib Magazins).

Trotz der leicht anders gearteten Herstellungspraxis und der leicht divergierenden Vorstellungen der Open Access und Self-Archiving Community liegt es daher nahe, auch deren Projekte unter eine Lizenz zu stellen, die

- den Einsatz von Open Content Lizenzen für die Inhalte der Open Access und Self-Archiving Projekte,

- das Versehen der Beispiel-Implementierungen von Self-Archiving Software und von evtl. zusammen mit den Artikeln verbreiteter Software mit Lizenzmodellen von Freier Software

vorsieht.

An dieser Stelle soll darüber hinaus vorgeschlagen und zur Diskussion gestellt werden, die bestehenden Lizenzen für Content (OPL, GFDL) - angesichts der hohen Bedeutung des Link-Konzepts im Web - um zwei Bedingungen so zu erweitern:

- dass die in ihren Texten aufgeführten Referenzen wiederum nur mit anderen elektronischen Volltexten verlinkt werden, so lange diese ebenfalls unter einer Open Content Lizenz stehen, und

- daß ein freier elektronischer Text nur dann von einem anderen Text aus verlinkt werden darf, wenn der andere ebenfalls frei ist. Texte, die unter S/L/P Lizenzen verbreitet werden, dürften den freien Text zwar referenzieren aber nicht verlinken.

Die Bedingung für das Verlinken von Referenzen würde derjenigen zur Verlinkung von Software-Bibliotheken bei Freier Software entsprechen, die ja auch nur dann zulässig ist, wenn diese Software-Bibliotheken ebenfalls frei sind. Nicht unter Open Content Lizenz stehende Texte würde natürlich weiterhin so, wie es seit Jahrhunderten üblich ist, als Referenz aufgeführt werden, jedoch nicht mit einem Link auf den elektronischen Volltext versehen. Diese Praxis scheint eine hohe Praktikabilität zu besitzen, zumal auch heute schon frei zugängliche wissenschaftliche Texte in aller Regel nur solche Texte verlinken, die ebenfalls frei zugänglich sind. Ähnlich wie in der Welt der Software würden mit der Zeit zwei Welten entstehen, die aufgrund der Lizenzbedingen unvereinbar sind: eine Welt der Verwertung von Inhalten und eine Welt der freien Inhalte. Für die Open Archives Initiative hätte dies z.B. zur Folge, daß in ihrem Metadaten Index nur freier Content verlinkt oder bei einer Suche als Ergebnis präsentiert sein kann.

Der Schritt dahin sollte eigentlich nicht zu gross sein, zumal es bereits Entwicklungen in diese Richtung gibt. Schon heute profitiert die Open Access und Self-Archiving Community von unter Open Source Lizenzen stehenden Content Management Systemen für den Betrieb von Open Access Ejournals oder Preprint-Servern, Suchmaschinen oder Indexierungstools. Auch werden bereits viele der bei den Self-Archiving Projekten entwickelten Software Tools und Beispiel-Implementierungen mit Freien Software Lizenzen verbreitet. Und was die Inhalte angeht, findet sich auf der Website der PloS eine sogenannte PloS-Lizenz 26 für ihre geplanten Open Access EJournals, die sich - laut eigener Aussage - die Lizenzmodelle der Open Source Bewegung zum Vorbild genommen hat. Auch das elektronische D-Lib Magazine, das Sprachrohr der Self-Archiving Community, hat ein einfaches Copyrightkonzept für ihren Content, der im Prinzip jegliche (nicht-kommerzielle) Nutzung erlaubt, so lange wie die Quelle angemessen zitiert wird. (Arms 2000c)

für ihre geplanten Open Access EJournals, die sich - laut eigener Aussage - die Lizenzmodelle der Open Source Bewegung zum Vorbild genommen hat. Auch das elektronische D-Lib Magazine, das Sprachrohr der Self-Archiving Community, hat ein einfaches Copyrightkonzept für ihren Content, der im Prinzip jegliche (nicht-kommerzielle) Nutzung erlaubt, so lange wie die Quelle angemessen zitiert wird. (Arms 2000c)

Fazit

Das Streben der Self-Archiving Community nach freier Vorveröffentlichung von wissenschaftlichen Zeitschriftenartikel in elektronischer Form noch bevor die Artikel bei Zeitschriften eingereicht werden und selbst danach, das Pochen auf ein Zweitveröffentlichungsrecht, unterminiert tendenziell die Verwertung dieser Inhalte über herkömmliche Vertriebskanäle. Ebenso wie kostenlos verbreitete Freie Software von ähnlicher Qualität wie proprietäre Software den Umsatz von proprietärer Software zugunsten von Freier Software beeinträchtigen kann, ist es möglich, dass kostenpflichtige Online-Zeitschriften in Zukunft zunehmend abbestellt und dafür einfach die frei zugänglichen wissenschaftlichen Aufsätze genutzt werden.

Die Frage, inwieweit kostenlose Digitale Bibliotheken einen Ausweg für die Zeitschriftenkrise darstellen, lässt sich nur auf mehreren Ebenen beantworten.

Zunächst ist natürlich festzustellen, dass "Kostenpflichtigkeit oder nicht?" nicht die entscheidende Frage ist. Wie gezeigt wurde, steht eine gratis-Verbreitung von Information einer Verwertung nicht entgegen und ein kostenloser Zugang auf vermehrt mit Werbung durchsetzte Fachinformation erscheint als wenig erstrebenswert und wird sich auch höchstens in Teilbereichen durchsetzen. (Bredemeier 1999)

Sodann wäre die Frage nach den Kräfteverhältnissen zwischen den verschiedenen antagonistischen Akteuren am Informationsmarkt zu stellen. Trotz jahrelanger enormer Preissteigerungen und mehreren Abbestellungsrunden bei Zeitschriftenabonnements scheinen sich Hochschulen nur schwer auf die gegebenen Preisstrukturen einstellen zu können - z.B. durch Abbestellen der Zeitschriften mit dem schlechtesten Preis-Leistungsverhältnis. (Obst 2000b) Im Moment ist es m.E. durchaus offen, wie es mit dem wissenschaftlichen Publizieren weitergeht oder wie es auf lange Sicht ausgeht. Tatsache ist, dass durch die Verlagerung des Print-Publizierens zum Elektronischen Publizieren in vergleichsweise kurzer Zeit ein enormer Umbruch vonstatten geht. In Delphi Studien wird den neuen elektronischen Alternativen (Preprint) jedenfalls mittelfristig das Potential eingeräumt im Zeitschriftenbereich einen langsamen Wandel herbeizuführen. (Keller 2001b) Das OAI System kann sich durchaus durchsetzen und eine zunehmend wichtige Rolle im wissenschaftlichen Publikationswesen spielen. Es ist allerdings unwahrscheinlich, dass die monopolartigen Verlagsstrukturen deswegen gleich zusammenbrechen und sich auf Nischen zurückziehen müssen - dazu haben sie zu gute Ausgangspositionen: Sie sind im Besitz der Verwertungsrechte an Zeitschriften und Monografien und haben langjährige Verträge mit den Autoren abgeschlossen. Sie verfügen ferner über viel Know How im Bereich des digitalen Publizierens, das sie bereits heute einsetzen um auch in der digitalen Publikationswelt bestehen zu können.

Die Freie Software Bewegung stellt Kapitalismus und Verwertung von Wert nicht grundsätzlich in Frage. Auch ist die Self-Archiving Vision der Befreiung des wissenschaftlichen Publikationswesens aus der "Geiselnahme" durch die S/L/P Verbreitungsweise nicht zu verwechseln mit einer grundlegenden Kritik an der Verwertung von wissenschaftlicher Information. Hin und wieder werden zwar die kommerziellen Verlage als Monopolisten hingestellt, ihr Profitstreben als die Wissenschaft behindernd dargestellt und die kommerzielle Verlagstätigkeit als keine "richtige" und deshalb in Teilen unverdiente Wertschöpfung kritisiert. Mehrfach haben sich die Protagonisten der Open Access und Self-Archiving Community jedoch gegen den Vorwurf des Antikapitalismus abgegrenzt und statt dessen für einen "fairen" Austausch mit den Verlagen plädiert, der diesen "angemessene" Profite wenn auch keine Monopolprofite ermöglicht.

Somit entbehrt die Auseinandersetzung um die Zeitschriftenkrise auch nicht einer gewissen Komik: Bibliotheken und Fachgesellschaften richten dramatische Appelle und offene Briefe an die Verleger, als könnten diese moralischen Zeigefinger die Sachzwänge des ökonomischen Handelns der Verlage beeinflussen. Diese reagieren wiederum mit Geschichten über wachsenden Umfang der Zeitschriften und bessere Qualität, als hätten sie es nötig, ihre Preise mit nachvollziehbaren Kostenstrukturen zu begründen.

Literaturverzeichnis

Arms, W. Y. (1997)

-

"Relaxing Assumptions about the Future of Digital Libraries." D-Lib Magazine(4/97)

Arms, W. Y. (2000a)

-

"Economic Models for Open Access Publishing." information impacts (iMP) 3

Arms, W. Y. (2000b)

-

Digital Libraries and Elektronisches Publizieren. London, MIT Press

Arms, W. Y. (2000c)

-

The Web as an Open Access Digital Library

Arms, W. Y. (2000d)

-

"Automated digital libraries." D-Lib Magazine

BOAI (2002)

-

Budapest Open Access Initiative

Case, M. M. (2002)

-

Capitalizing on Competition: The Economic Underpinnings of SPARC

DINI (2000)

-

"DINI-Apell. Open Archive Initiative an deutschen Hochschulen." Bibliotheksdienst(10)

FLOSS (2002)

-

FLOSS Final Report Part III: Free / Libre Open Source Software: Survey and Study. Basics of Open Source Software Markets and Business Models

Ginsparg, P. (1996)

-

Winners and Losers in the Global Research Village. UNESCO Conference, Paris, 19.-23. Februar 1996

Ginsparg, P. (1997)

-

Electronic research archives for physics. The Impact of Electronic Publishing on the Academic Community, Wenner-Gren Center, Stockholm, Portland Press Ltd.

Grassmuck, V. (2000)

-

Freie Software. Geschichte, Dynamiken und gesellschaftliche Bezüge

Grötschel, M. and J. Luegger (1995)

-

Wissenschaftliche Kommunikation am Wendepunkt - Bibliotheken im Zeitalter Globaler Elektronischer Netze

Grötschel, M., J. Luegger, et al. (1993)

-

Wissenschaftliches Publizieren und Elektronische Fachinformation im Umbruch: ein Situationsbericht aus der Sicht der Mathematik

Harnad, S. (1995)

-

PostGutenberg Galaxy . I am speaking ONLY about refereed journal articles, not books or magazines

Harnad, S. (1998a)

-

For Whom the Gates Toll? How and Why to Free the Refereed Literature Online Through Author / Institution Self-Archiving, Now

Harnad, S. (1998b)

-

"On-Line Journals and Financial Fire-Walls." Nature 395: 127-128

Harnad, S. (1999)

-

"Free at Last: The Future of Peer-Reviewed Journals." D-Lib Magazine 5(12)

Harnad, S. (2000b)

-

"The Invisible Hand of Peer Review." Exploit Interactive(5)

Harnad, S. (2001a)

-

"E-Knowledge: Freeing the Refereed Journal Corpus Online." Computer Law & Security Report 16(2): 78-87

Harnad, S. (2001b)

-

For Whom the Gates Toll? How and Why to Free the Refereed Literature Online Through Author / Institution Self-Archiving, Now

Harnad, S. (2001c)

-

"The Author/Institution Self-Archiving Initiative. To Free the Refereed Research Literature Online."

Harnad, S., H. Varian, et al. (2000a)

-

Academic publishing in the online era: What will be for-fee and what will be for-free?

Keller, A. (2001b)

-

"Future Development of electronic journals: a Delphi survey." The Electronic Library 19(6): 383-396

Maly, K., M. Zubair, et al. (2001)

-

"Kepler - An OAI Data/Service Provider for the Individual." D-Lib Magazine 7(4)

Meier, M. (2002)

-

Returning Science to the Scientists. Der Umbruch im STM - Zeitschriftenmarkt unter Einfluss des Electronic Publishing. München, peniope

Meretz, S. (2000)

-

LINUX & CO. Freie Software - Ideen für eine andere Gesellschaft

Obst, O. (2000b)

-

"Zeitschrftenmanagement II: Zeitschriftenbedürfnisse und Bewertungskonzepte." Bibliotheksdienst 34(7/8): 1194-1210

Odlyzko, A. (1995)

-

"Tragic Loss or Good Riddance? The impending demise of traditional scholarly journals." Intern. Journal of Human Computer Studies(42): 71-122

Odlyzko, A. (1997)

-

"The Economics of Electronic Journals." First Monday 8(2)

Odlyzko, A. (1999)

-

Competition and cooperation: Libraries and publishers in the transition to electronic scholarly journals

Outsell (2000)

-

Industry Trends, Size and Players in the Scientific, Technical & Medical (STM) Market, California. Burlingame, Outsell Inc.

Price, D. J. (1956)

-

"The exponential curve of science." Discovery 17: 240-243

Rosenblatt, B. (1997)

-

"Solving the Dilemma of Copyright Protection Online." Journal of Electronic Publishing 3(2)

Sietmann, R. (2000)

-

"Eine Zeitschrift auf den Server einer Universität zu legen, ist keine große Leistung". Interview mit Arnoud deKemp

Sompel, H. V. d. and C. Lagoze (2000)

-

"The Santa Fe Convention of the Open Archives Initiative." D-Lib Magazine 6(2)

SPARC (2000)

-

"Declaring Independance. A Guide to Declaring Community Controlled Science Journals."

Tenopir, C. and D. W. King (2002)

-

"Designing Electronic Journals With 30 Years of Lessons from Print." Journal of Electronic Publishing(4)

Wyly, B. J. (1998)

-

"Competition in Scholarly Publishing? What Publishers Profits reveal." ARL Newsletter(200)

1 Im Vergleich dazu hatte der US Fachbuchmarkt 2001 ein Volumen von 5,4 Mrd US$ und der von Schulbüchern einen von 4,2 Mrd US$). Der E-Commerce Anteil war mit 1,8 Mrd US$ noch gering (7,2%).

Im Vergleich dazu hatte der US Fachbuchmarkt 2001 ein Volumen von 5,4 Mrd US$ und der von Schulbüchern einen von 4,2 Mrd US$). Der E-Commerce Anteil war mit 1,8 Mrd US$ noch gering (7,2%).

2 Nationale und Zentrale Fachbibliotheken (8), Regionalbibliotheken (39), Universitätsbibliotheken (79), Hoch- und Fachhochschulbibliotheken (176) und wissenschaftliche Spezialbibliotheken (909)

Nationale und Zentrale Fachbibliotheken (8), Regionalbibliotheken (39), Universitätsbibliotheken (79), Hoch- und Fachhochschulbibliotheken (176) und wissenschaftliche Spezialbibliotheken (909)

3 Achtung: die Bibliotheksstatistik liefert nur die Zahlen der Bibliotheken, die daran teilnehmen. Viele dezentralen Bibliotheken des zweischichtigen deutschen Systems haben sich nicht beteiligt. Die Gesamtausgaben könnten bei 2,5 Mrd DM liegen.

Achtung: die Bibliotheksstatistik liefert nur die Zahlen der Bibliotheken, die daran teilnehmen. Viele dezentralen Bibliotheken des zweischichtigen deutschen Systems haben sich nicht beteiligt. Die Gesamtausgaben könnten bei 2,5 Mrd DM liegen.

4 Ende der 90er Jahre fanden mindestens 6 größere Merger im Bereich der wissenschaftlicher Verlage statt. Reed Elsevier (952 Mio US$ STM-Umsatz} und Wolters Kluwer (359 Mio US$ STM-Umsatz} versuchten im Jahr 1997 einen Merger, der allerdings an den Kartellbehörden scheiterte. Es kann gezeigt werden, daß diese Merger zu Preissteigerungen der jeweiligen Fachzeitschriften Portfolios führen bzw. sogar aus gerade diesem Grund angestrebt werden. Die Profite der großen Fachverlage sind überdurchschnittlich im Vergleich mit dem Publikationsmarkt. According to Reed Elsevier's annual report, the operating margin of the Scientific segment ran at 40.28% (1997), 41,77% (1996), and 39,66% (1995) as a percentage of sales. As a point of comparison, Microsoft's operating incomee as a percentage of sales was 45, 17% for 1997, 35,50% in 1996 and 34.33% in 1995. Wyly, B. J. (1998). "Competition in Scholarly Publishing? What Publishers Profits reveal." ARL Newsletter(200) http://www.arl.org/newsltr/200/wyly.html

Ende der 90er Jahre fanden mindestens 6 größere Merger im Bereich der wissenschaftlicher Verlage statt. Reed Elsevier (952 Mio US$ STM-Umsatz} und Wolters Kluwer (359 Mio US$ STM-Umsatz} versuchten im Jahr 1997 einen Merger, der allerdings an den Kartellbehörden scheiterte. Es kann gezeigt werden, daß diese Merger zu Preissteigerungen der jeweiligen Fachzeitschriften Portfolios führen bzw. sogar aus gerade diesem Grund angestrebt werden. Die Profite der großen Fachverlage sind überdurchschnittlich im Vergleich mit dem Publikationsmarkt. According to Reed Elsevier's annual report, the operating margin of the Scientific segment ran at 40.28% (1997), 41,77% (1996), and 39,66% (1995) as a percentage of sales. As a point of comparison, Microsoft's operating incomee as a percentage of sales was 45, 17% for 1997, 35,50% in 1996 and 34.33% in 1995. Wyly, B. J. (1998). "Competition in Scholarly Publishing? What Publishers Profits reveal." ARL Newsletter(200) http://www.arl.org/newsltr/200/wyly.html .

.

5 Etwa 40% des Umsatzes mit wissenschaftlichen Zeitschriften wird von kommerziellen Verlagen gemacht, der Rest sind Fachgesellschaften, unkommerzielle Verlage, etc.

Etwa 40% des Umsatzes mit wissenschaftlichen Zeitschriften wird von kommerziellen Verlagen gemacht, der Rest sind Fachgesellschaften, unkommerzielle Verlage, etc.

6 Es gibt sogar Fachzeitschriften, die nicht nur teure Abogebühren von den Nutzern sondern auch sog. page-charges (z.B. 500$ pro Artikel oder einige zig $ pro Seite) von den Autoren verlangen.

Es gibt sogar Fachzeitschriften, die nicht nur teure Abogebühren von den Nutzern sondern auch sog. page-charges (z.B. 500$ pro Artikel oder einige zig $ pro Seite) von den Autoren verlangen.

7 Von Fach zu Fach sehr verschieden wird diese Praxis der Vorveröffentlichung entweder toleriert oder durch Nichtpublizieren eines eingereichten Artikels sanktioniert.

Von Fach zu Fach sehr verschieden wird diese Praxis der Vorveröffentlichung entweder toleriert oder durch Nichtpublizieren eines eingereichten Artikels sanktioniert.

8 S/L/P = Subscription/Site License/Pay-Per-View

S/L/P = Subscription/Site License/Pay-Per-View

9 Selbstverständlich ist das Veröffentlichen eines Artikels als Preprint eine Form des Publizierens, insbesondere, wenn dieser Artikel vorher nirgendwo erschienen ist. Verlage sollen aber davon Abstand nehmen sollen, bereits als Preprints veröffentlichte Artikel kategorisch von einer Publikation in einer Zeitschrift auszuschließen.

Selbstverständlich ist das Veröffentlichen eines Artikels als Preprint eine Form des Publizierens, insbesondere, wenn dieser Artikel vorher nirgendwo erschienen ist. Verlage sollen aber davon Abstand nehmen sollen, bereits als Preprints veröffentlichte Artikel kategorisch von einer Publikation in einer Zeitschrift auszuschließen.

11 http://citebase.eprints.org/cgi-bin/search

http://citebase.eprints.org/cgi-bin/search

12 RFC = Request for Comments. Technische Entwürfe für Verbesserungen des Internets, die vom der Internet Engineering Task Force zirkuliert werden. Eine unkonventionelle Peer-Review Variante.

RFC = Request for Comments. Technische Entwürfe für Verbesserungen des Internets, die vom der Internet Engineering Task Force zirkuliert werden. Eine unkonventionelle Peer-Review Variante.

13 EPrints ist heute ein Teil des GNU Projekts und steht damit unter der GNU General Public License (GPL). Für die Zukunft behält sich die University of Southampton das Recht vor, zusätzlich zu der GPL-Version auch nicht GPL-Versionen der Eprints Software zu veröffentlichen: "We may do this as a way of getting funding to keep maintaining the free version." http://software.eprints.org/gnu.php

EPrints ist heute ein Teil des GNU Projekts und steht damit unter der GNU General Public License (GPL). Für die Zukunft behält sich die University of Southampton das Recht vor, zusätzlich zu der GPL-Version auch nicht GPL-Versionen der Eprints Software zu veröffentlichen: "We may do this as a way of getting funding to keep maintaining the free version." http://software.eprints.org/gnu.php , http://software.eprints.org/

, http://software.eprints.org/

14 vgl. http://kepler.cs.odu.edu/